23生产实习 Day01(05/29) Hadoop运行环境搭建及配置

Day01(05/29) Hadoop运行环境搭建及配置

0.软件环境准备

虚拟化平台,VMware Workstation 16 Pro

虚拟机镜像,CentOS7, ISO:CentOS-7-x86_64-DVD-2207-02.iso

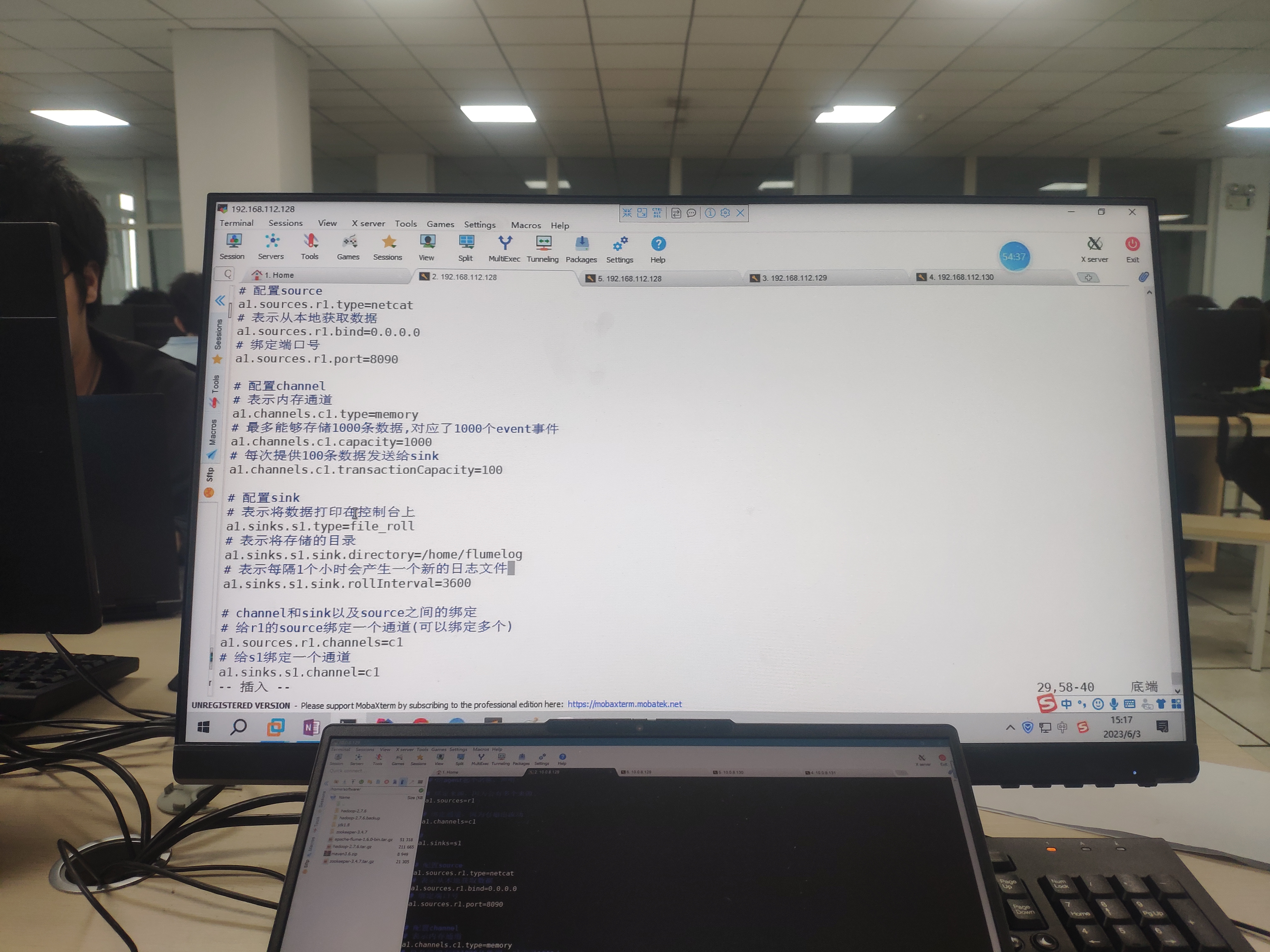

远程连接工具, MobaXterm

一台笔电,操作系统为Win10Pro

相关资源文件,放在共享网盘资源里了(博客首页左侧的公告)

1 | hadoop-2.7.6.tar.gz # hadoop安装包 |

1.关闭防火墙

1 | sudo systemctl stop firewalld # 临时关闭 |

2.配置主机名称

a. 注意:在Hadoop集群中的主机名称不能存在_和-,如果存在则会导致Hadoop在集群中无法找到该节点

b. 编辑文件:vim /etc/hostname

c. 将主机名称进行指定然后保存退出

3.配置hosts文件,将主机名称和ip地址进行映射

1 | vim /etc/hosts # 编辑hosts文件 |

4.重新启动虚拟机让所有的配置进行生效

在当前节点输入:reboot

5.配置SSH免密互通

1 | ssh-keygen # 生成自己的公钥和秘钥 |

6.进入Hadoop安装目录的子目录

cd /home/software/hadoop-2.7.6/etc/hadoop/

a. 编辑hadoop-env.sh文件

vim打开显示行号功能,进入一般命令模式(ESC),输入:set nu

1 | 1) 修改第25行JAVA_HOME的路径: |

b. 编辑core-site.xml文件

1 | <property> |

c.编辑hdfs-site.xml文件

1 | <property> |

d.编辑mapred-site.xml文件

将mapred-site.xml.template模板文件复制一份并且重命名为mapred-site.xml

cp mapred-site.xml.template mapred-site.xml

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 AriesfunのBlog!

评论